Puisque l'ultra haute définition ( UHD ) commence à arriver dans nos foyers, c'est le moment idéal pour s'interroger sur les enjeux et les impacts techniques et économiques de ce format. Je vous propose une suite d'articles qui permettront de comprendre ce qui est spécifié, comment les acteurs industriels se préparent à y répondre, quels sont les types de produits existants et ceux qui pourraient arriver sur le marché.

Cette première partie est dédiée à la description simplifiée des caractéristiques majeures exploités par les différents types de signaux vidéos ultra HD. Sont décrits les éléments suivants :

• 1.1 Résolutions et aspects d'images

• 1.2 Fréquences d'images

• 1.3 Le High Frame Rate ( HFR )

• 1.4 Espace colorimétrique - Wide gamut

• 1.5 Représentation colorimétrique

• 1.6 Représentation numérique, profondeur de couleur

• 1.7 High Dynamic Range ( HDR )

• 1.8 High Efficiency Video Coding ( HEVC/H.265 )

• 1.9 Connectique, interface - HDMI 2.0, Display port 1.3

• 1.10 Le HDCP 2.2

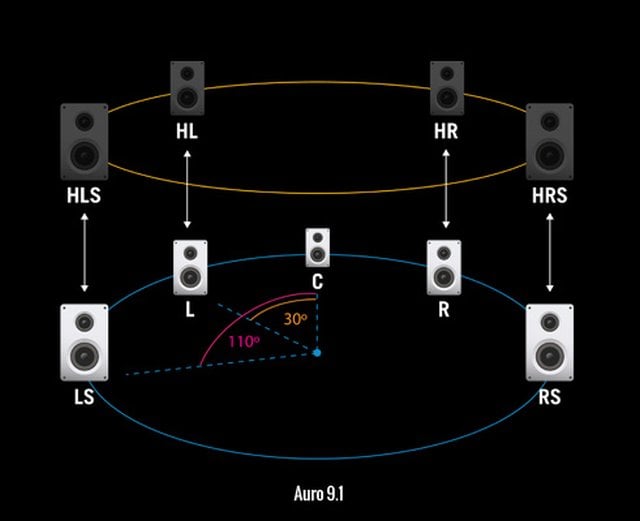

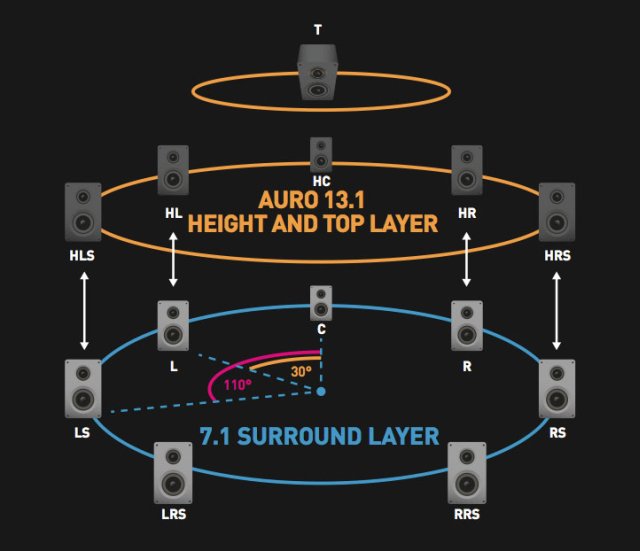

• 1.11 Les formats audio immersifs / 3D

Convention pour ce qui suit :

- La définition est caractérisée par le nombre total de pixels dans l'image exprimée en nombres de pixels. Ex. : 7 Mpixels.

- La résolution se caractérise par le nombre de pixels par unité de longueur, c'est en fait la densité de pixels de l'image. Celle-ci n'a rien à voir avec le nombre de pixels." La résolution s'exprime en dpi (dot per inch = point d'encre par pouce) pour une imprimante, ou en ppp (pixel par pouce) pour un fichier image.

L'ultra HD est l'appellation générique d'une multitude de format vidéos existants, chacun couvrant un domaine d'application différent ( télévision, Bluray, internet ). Dans chaque domaine d'application, des organismes adaptés ont ou vont précisés(r) les paramètres d'un format vidéo ultra HD ainsi que les appellations associées. Il y a donc de nombreux documents / standards / normes décrivant une forme de signal vidéo dite ultra HD.

Par exemple, dans le cas d'un signal télévisé, il existe une norme qui fait référence et qui est spécifiée par l'International Telecommunication Union ( ITU ). Il s'agit des recommandations en matière de paramètres de production et de diffusion télévisé de l'ultra haute définition ( Document ITU-R BT.2020-1 crée en 2012 et mis à jour en 2014 ). A partir de ce document, les Etats-Unis peuvent définir leur propre standard télévisé ultra HD, tout comme le font l'Europe et le Japon avec des paramètres différents. Mais dans tous les cas, les paramètres vidéos de chaque standard ultra HD télévisé devront faire partit de ceux recommandés par l'ITU.

Pour les vidéos ( films, concerts, documentaires ) stockés sur support physique optique ( Ultra HD Blu-ray ):

Les spécifications de l'ultra Blu-ray diffusées en janvier 2015 précisent qu'une seule définition d'image ( supérieure à la définition Full HD ) est admise :

• Définition : 3840 x 2160 pixels

Aspect d'image : 16/9è soit un rapport de forme de 1,77.

La définition d'image 4096 X 2160 n'est pas retenue pour l'Ultra Blu-ray.

Pour la diffusion TV ( Broadcasting c'est à dire via satellite ou TNT, Broadbanding c'est à dire via boîtier internet ou live via site internet ) :

Reprenant les recommandations de l'ITU en matière de production et de diffusion télévisé d'un signal ultra HD, l'organisme chargé de rédiger les standards Télévisuels, le SMPTE ( Society of Motion Picture and Television Engineers ), a crée en 2007 puis mis à jour en 2009 et 2013 les documents référencés SMPTE ST-2036-1, 2036-2, 2036-3 qui définissent, plus en détails, les différents paramètres de production d'un signal ultra HD télévisé. On parle alors de UHDTV qui se décline en deux définitions:

• Définition : 3840 x 2160 pixels (8.3 megapixels)

Aspect d'image : 16/9è soit un rapport de forme de 1,77.

Appellation générique du format de production : UHDTV1

L'UHDTV1 est alors diffusé dans des formats propre au Japon ( nommé Super-Hi-Vision 4K ), à l'Europe ( nommé UHD-1 ), aux Etats-Unis ( non définie ) avec des paramètres propres choisit parmi les recommandations de l'ITU.

• Définition : 7680 x 4320 pixels (33,2 megapixels)

Aspect d'image : 16/9è soit un rapport de forme de 1,77.

Appellation générique du format de production : UHDTV2

L'UHDTV2 est alors diffusé dans des formats propre au Japon ( nommé Super-Hi-Vision 8K ), à l'Europe ( nommé UHD-2 ), aux Etats-Unis ( non définie ) avec des paramètres propres choisit parmi les recommandations de l'ITU.

Pour information, le format UHDTV2 est basé sur les paramètres du format "Super hi-vision 8K" définit par NHK ( Media N°1 de diffusion télé au Japon ) pour la diffusion 8K via satellite au Japon.

A noter ici que les différentes définitions 4K issue du cinéma numérique ne pouvaient être retenues pour la diffusion TV du fait que l'aspect d'image unique retenue est le 16/9ème.

Pour les vidéos ( films, concerts, documentaires ) disponible en streaming ou via des sites de vidéo à la demande :

Le CEA met à jour en mai 2013, le document technique spécifiant les paramètres des formats vidéo numériques non compressés pouvant être exploités ( document CEA-861-F ) avec les définitions suivantes :

• Définition : 3840 x 2160 pixels

Aspect d'image : 16/9è soit un rapport de forme de 1,77.

• Définition : 4096 x 2160 pixels

Aspect d'image : 17/9è soit un rapport de forme de 1,90.

Ces deux formats de définition peuvent être exploités à différentes fréquences d'images par secondes ( voir plus bas ).

Le format de définition 4096x2160 existait déjà dans le monde du cinéma numérique, le CEA l'a donc porté comme format de définition possible pour usage domestique. Le DCI 4K ( spécifié par Digital Cinéma Initiatives et appelé communément 4K ) est un format répandue dans l'industrie du cinéma et prend comme définition 4096 x 2160 pour un rapport de forme de 1,90 ( aspect d'image de 17,06/9è ). A noter que les vidéos projecteurs Sony 4K possèdent des matrices compatibles jusqu'à la définition de 4096 x 2160 ( et pas seulement jusqu'à la définition 3840x2160 ).

Puisque le format de définition 4096x2160 n'est pas 16/9è, cela va poser quelques complications pour nos diffuseurs :

• 99% des téléviseurs actuels et à venir sont en 16/9è, une toute petite partie sera en 21/9è.

• on peut parier que la majorité des vidéo projecteurs à venir seront en UHD et la minorité ( haut de gamme ) ira jusqu'à la définition dite 4K.

En théorie, ce sont ces définitions d'images du standard CEA-861-F qui s'appliqueront mais, ... comme le monde internet à parfois tendance à privilégier ses propres besoins, on devrait s'attendre dans les premiers mois à des formats de vidéos dont les définitions et aspects d'images seront plus ou moins exotiques par rapport a ce que le CEA a spécifié.

Résumé des définitions, de leurs applications et des appellations associées :

Il faut distinguer la sémantique crée pour servir un discours de nature commerciale avec la sémantique propre aux normes techniques.

Dans le langage commercial, il y a des ambiguïtés qui ne servent pas le consommateur à décoder correctement le type de produit qui lui est proposé. On considère que tout ce qui a une définition d'au moins 3840x2160 peut être nommé Ultra HD ou UHD de manière générique, avec des spécificités supplémentaires en fonction des continents :

• En Amérique du Nord, les produits commercialisés ayant une définition de 3840x2160 ou 4096x2160 peuvent être nommés Ultra HD ou bien UHD ou bien 4K. Un téléviseur de définition 7680x4320 peut très bien être appelé Ultra HD ou bien UHD ou bien 8K.

• En Europe, seuls les produits commercialisés de définition 3840x2160 peuvent être appelés Ultra HD ou UHD. Les autres définitions ne sont pas prises en compte.

En résumé, dans le langage commercial, les américains ont agrégés des termes afin de ne plus permettre la distinction entre définitions ( ce qui crée une certaine ambiguïté de mon point de vue ) et les Européens ont nommé qu'une seule et unique définition.

De plus le terme 4K est employé pour identifier les produits commercialisés qui ne proposent qu'une augmentation de la définition ( 3840x2160 ) tout en conservant l'ensemble des paramètres de la norme Full HD. Il n'y a donc aucune relation entre le terme 4K qui renvoi à la définition du cinéma numérique et le terme 4K "commercial".

Derrière ces termes commerciaux "fourre tout" que sont Ultra HD, UHD et 4K, il existe une multitude de standards techniques aux appellations précises que je vous liste en fonction des définitions associées :

• QUAD HD/QUAD HDTV/4K2K sont les noms commerciaux associés au format vidéo QFHD ( Quad Full High Definition ) de définition 3840x2160 qui est désormais obsolète. Les premiers téléviseurs prototypes de définition 3840x2160 présentés dans les salons entre fin 2011 et mi 2013 ont ainsi été nommés. Les termes commerciaux Quad HD / Quad HDTV / 4K2K sont obsolètes et ont été remplacés par les terme commerciaux UHD ou Ultra HD.

• 3840x2160 est une définition 16/9è utilisé par :

- l'UHD-1 ( nom du format ultra HD de première génération pour les télévisions Européennes ),

- le Super Hi-Vision 4K ( nom du format ultra HD de première génération pour les télévisions Japonaises ),

- le format ultra HD, pas encore spécifié par l'ATSC ( 3.0 ), de première génération pour les télévisions en Amérique du Nord. Ce format pourrait s'appeler "4K UHD" ou "4K".

- l'Ultra HD Blu-ray.

• 4096x2160 est une définition non 16/9è utilisé par :

- le standard DCI 4K ( utilisé par le cinéma numérique ),

• 7680x4320 est une définition 16/9è utilisé par :

- l'UHD-2 ( nom du format ultra HD de deuxième génération pour les télévisions Européennes ),

- le Super Hi-Vision 8K ( nom du format ultra HD de deuxième génération pour les télévisions Japonaises ),

- le format ultra HD, pas encore spécifié par l'ATSC ( 3.0 ), de deuxième génération pour les télévisions en Amérique du Nord. Ce format pourrait s'appeler "8K UHD" ou "8K".

• 8192x4320 est une définition non 16/9è et exploité par aucun standard ( pour le moment ) que ce soit dans le monde du cinéma numérique, de la télévision ou pour application domestique. Les laboratoires R&D de NHK et JVC ont développé un système exploitant cette définition. A noter aussi que ce format de définition est le format de sortie le plus élevé autorisé par l'HEVC.

Pour les vidéos ( films, concerts, documentaires ) stockés sur support physique optique ( Ultra HD Blu-ray ):

Les fréquences admises par l'Ultra HD Blu-ray sont de :

• 2D : 23.976p, 24p, 25p, 50p, 59.94p, 60p ( si encodage en HEVC ) et 23.976p, 24p ( si encodage en AVC ),

A noter que même si aucun format UHD 3D n'est spécifié à ce jour ( janvier 2015 ), l'Ultra HD Blu-ray autorise les vidéos Full HD 3D :

• 3D: 48p (24p par œil) > Frame packet

Le HFR 3D ( 96p soit 48p par œil ) que Peter Jackson et James Cameron exploitent en captation 3D pour leurs films n'est pas spécifié pour le moment pour un usage domestique ( ni en définition Full HD, ni en définition UHD ).

Pour la diffusion TV ( Broadcasting c'est à dire via satellite ou TNT, Broadbanding c'est à dire via boîtier internet ou live via site internet ) :

Les fréquences admises par SMPTE en UHDTV1 et en UHDTV2 sont les suivantes ( mars 2014 ) :

Pour la diffusion 3D, le format n'est pas arrêté, c'est à l'étude. SMPTE préconise l'utilisation de la plein définition pour chaque image ce qui signifierait que les fréquences progressives de 50/60hz soient un minimum pour afficher cette UHDTV en 3D.

L'UHDTV est d’emblée du progressif alors que la télévision actuelle est diffusée en entrelacé à savoir des demi-images envoyées en mode entrelacé. Cela explique pourquoi l’UHDTV1@50p multiplie en théorie ( par rapport a un signal HDTV@50p ) le débit nécessaire par 8 (hors améliorations liées à l’HEVC) : 2*2 du fait du doublement du nombre de pixels en hauteur et en largeur et encore *2 du fait du passage au signal progressif.

Pour les vidéos ( films, concerts, documentaires ) disponible en streaming ou via des sites de vidéo à la demande :

Les fréquences admises par le standard UHD du CEA sont de 23.976/24/25/30/50/59.94/60 images/s uniquement en progressif.

Généralités :

Toute fréquence d'affichage supérieure à 60hz ( cas de la diffusion TV ) ou à 24hz ( cas de la diffusion cinéma ) est considérée comme HFR.

L'illusion de mouvement et l'origine du 24hz au cinéma :

Le phénomène de la persistance rétinienne est observé au XVIIIe siècle par le Franco-Irlandais Chevalier d'Arcy qui fabrique un disque rotatif sur le périmètre duquel est fixé un charbon ardent. À partir d'une vitesse de rotation de sept tours à la seconde, le charbon ardent donne l'illusion d'un cercle lumineux continu, « qu'il ne pouvait être attribuée qu'à la durée de la sensation ». Il en déduit que la perception de mouvement chez l'homme serait le résultat d'une vision persistante composée d'au moins 7 images par secondes.

C'est en 1891 que Thomas Edison et Dickinson présentent le premier film animé grâce à la première caméra ( nommée Kinétographe ). Les prises de vues varient de 18 images par seconde à 46 images par seconde grâce à un moteur asynchrone pouvant entraîner le mécanisme plus rapidement à la demande. Leur expérimentations montrent qu'Une cadence de moins de 16 images par seconde (trame/s) pouvait provoquer la perception d'images clignotantes. Le mouvement reste interprétable même à une taux de 10 images par seconde ou encore plus lent, mais le scintillement causé par l'obturation d'un projecteur de film devient distrayant en dessous du seuil de 16 images par secondes.

Avant 1926, les films muets étaient tournés et projetés à la vitesse maximale de 16 images par seconde. Avec l’arrivée du parlant (The jazz singer en 1927), l’industrie a du augmenter la cadence de défilement des images : à 16 images par seconde, il n’est pas possible de retranscrire les hautes fréquences sonores. La reproduction des aigus exige un défilement plus rapide de la piste optique sonore couchée sur la pellicule. Le choix s’est porté sur une cadence de 24 images par seconde, qui permet non seulement une bonne lecture du son mais aussi une retranscription assez naturelle des mouvements à l’écran. Le format 24 images par seconde est ainsi devenu la norme mais moins pour des raisons artistiques et techniques qu’économiques : ce choix résulte d’un compromis entre les contraintes de rythme de diffusion des images et des sons et le coût de la pellicule. L’industrie aurait pu adopter un standard à 48 i/s. La qualité de la projection aurait été très différente mais cela aurait fait exploser les coûts de production et de distribution. Tant que le cinéma a utilisé les supports argentiques, les tentatives de High Frame Rate, comme le procédé showscan (projection de films 70 millimètres à 60 images / seconde), ont échoué à cause de leur coût trop élevé. Du coup, le 24 i/s n’a jamais été remis en cause pendant près d’un siècle.

Pour nous donner l’impression d’un mouvement fluide et non saccadé, le mécanisme d’entraînement du projecteur doit présenter cette pellicule à la lampe lumineuse de l’appareil d’une façon particulière : non pas en continu, mais en immobilisant durant une fraction de seconde chaque image devant l’objectif du projecteur. Entre deux immobilisations, un obturateur vient s’interposer entre la lampe et la pellicule pour créer un noir qui empêche de voir le déplacement d’une image à l’autre. Autrement dit, à chaque seconde, 24 images alterneraient avec 24 « noirs » sur l’écran de cinéma. Alterneraient, car en réalité, c’est deux fois plus d’images et de noirs qui se succèdent, soit 48. C’est que l’obturateur passe non seulement entre les images, mais aussi une fois sur l’image elle-même. Pourquoi ? Simplement parce que c’est à partir d’environ 50 images par seconde que notre œil voit plutôt la projection comme une lumière continue.

On a longtemps invoqué un phénomène appelé « persistance rétinienne » pour expliquer l’origine de l’illusion du mouvement que l’on expérimente sur le grand écran. Cette explication a cependant été rejetée par les psychologues pour plusieurs raisons. D’abord parce que nous continuons d’avoir une impression de mouvement quand les images fixes nous sont présentées à un rythme aussi bas que dix images par secondes et même moins. Plus embêtant encore pour cette théorie, la persistance rétinienne n’apparaît qu’environ 50 millisecondes après la cessation de l’image. Or durant cette période, au moins deux images fixes sont vues par le spectateur lors d’une projection normale. Par conséquent la première image du film ne « persisterait » pas avant l’apparition de la deuxième, ce qui cause un sérieux problème à la thèse de la fusion des images persistantes pour assurer l’effet de mouvement…

L’illusion du mouvement au cinéma serait donc produite par un autre phénomène qu’on appelle l’effet bêta . Celui-ci se manifeste dès que deux images légèrement décalées sont présentées rapidement l’une à la suite de l’autre. Notre cerveau y voit alors automatiquement un mouvement, résultat du travail d’intégration des champs récepteurs des cellules rétiniennes et des différentes aires corticales visuelles impliquée dans la détection et l’orientation du mouvement. Nous sommes donc en quelque sorte victimes de l’effet bêta chaque fois que nous voyons des images fixes se succéder rapidement devant nous.

Les insectes, aux liaisons nerveuses ultra-courtes, perçoivent le monde en moyenne à raison de 300 images par seconde. Ils ne verraient, s'ils désiraient aller au cinéma, qu'une succession paresseuses d'images différentes mais parfaitement immobiles.

A quelle fréquence percevons nous la réalité :

Les études montrent que la plupart des êtres humains voient 66 images par secondes. C'est à cette fréquence que nos yeux perçoivent le réel. Les données vues doivent être filtrées par le cerveau qui, à l'aide de cartes mentales, transforme ces informations en réalité perçue ayant un sens. Nous savons désormais que le processus de traitement des données du cerveau humain est de 40 hz. Ce qui signifie que :

• La réalité perçue est vue comme réaliste par le cerveau si on l'abreuve d'au moins 40 images par secondes.

• le cerveau humain n'est parfaitement conscient que de 40 des 66 images que nos yeux captent.

En dessous de cette fréquence de 40hz, le cerveau saura que ce qui lui est envoyé n'est pas "réel".

Pourquoi avoir besoin de hautes fréquences d'affichages ?:

Les standards de vitesses d'images datent de plus de 60 ans pour le cinéma et la télévision. L'augmentation de la définition d'image et de la taille des diffuseurs a eu pour effet d'augmenter les défauts visibles à l'image. La définition dynamique de la HD est comparable à celle de la SD :

Dans les deux cas, malgré l'amélioration de la définition, il y a une grande différence entre la définition statique et la définition dynamique ce qui entraîne une sensation de nausée. L'accroissement de la définition statique doit ainsi être suivie aussi d'une amélioration de la définition dynamique ( ce qui n'a pas été fait lors du passage de la SD à la HD ). Il aurait été possible de réaliser un upscaling des fréquences d'origines mais dans ce cas on crée de la fausse HFR à l'écran avec des images captées à basse fréquences et donc contenant les défauts visibles. Il faut donc augmenter les fréquences de captations, de diffusions et d'affichages en même temps.

Ci dessus, la même scène en mouvement est captée à des fréquences différentes : On constate des différences de netteté notamment sur les sabots du cheval et en arrière plan. Le zoom montre bien qu'il est inutile d'augmenter la définition d'image si la fréquence de captation n'est pas suffisante. C'est pour cette raison que les démonstrations d'écrans UHD en magasin se font généralement sur des vidéos ne comprenant que des scènes statiques ...

• Le laboratoire R&D Orange Labs a réalisé des tests sur une échelle normée allant de 0 à 100 : ils ont relevé un gain de 10 points apporté par l'augmentation de la définition ( passage de la même séquence en UHD par rapport au Full HD ) et un gain de 20 points pour le passage de 60hz à 120hz ( quel que soit la définition utilisée ). Autrement dit, l'amélioration de la fréquence d'image amène un gain supérieur à l'amélioration de la définition d'image.

Une des problématiques à traiter est que contrairement aux récepteurs des cellules rétiniennes qui permettent à l'oeil de distinguer plusieurs objets évoluant à plusieurs vitesses sans effets de rémanence et de flous, une caméra ne possède que des paramètres identiques pour toute l'image captée quel que soit le nombre d'objets évoluant dans l'image et leur vitesse relative. Ainsi la fréquence de captation et donc d'affichage sur l'écran doit être adaptée à de nombreuses situations. Si la vitesse de captation n'est pas adaptée à la scène filmée, on risque de voir à l'affichage des artefacts comme le flickering ( saccades ), les effets stroboscopiques, ou encore les flous de bougés lors de mouvements rapides qui engendrent une perte de précision à l'image.

• D'après le laboratoire R&D de la NHK ( Japan Broadcasting Corporation ) qui a réalisé des tests selon un processus normé, les résultats démontrent qu'il faut une fréquence :

supérieure à 80hz pour éviter un maximum de saccades,

supérieure à 100hz pour éviter les effets stroboscopiques,

supérieure à 200hz pour éviter les flous de bougés lors de mouvements rapides.

C'est pour ces raisons que la fréquence unique de fonctionnement du Super Hi-Vision 8K a été définie à 120hz.

• Le laboratoire R&D de Sony a réalisé des tests de fréquences de séquences vidéos comprises entre 60 et 480 hz :

Il faut un minimum de 250 hz pour annuler tout effet de saccades et de flous de bougés lors de mouvements rapides. C'est ce qui a amené Sony à définir la fréquence de 240hz, compatible avec les fréquences de 24 et 60 hz, comme haute fréquence à favoriser. Le choix d'une fréquence élevée réduisant considérablement les effets de bougés permet d'augmenter l'efficacité de l'algorithme prédictif du HEVC et donc de réduire le temps d'encodage en HEVC tout en améliorant la qualité d'image.

• La fréquence progressive de 50p n’est pas suffisante pour les scènes rapides ( travelling, sport, ... ). De plus les premiers tests de captations à 60hz en UHD pour des matchs de foot ont mis en évidence des interférences gênantes liées à des phénomènes de battements avec la fréquence secteur. ATEME et Orange planchent sur une solution intermédiaire qui consisterait à faire du 120p mais en entrelacé (une demi-image 120 fois par seconde) qui apporterait les bénéfices du 120p en perception des mouvements, et éviterait d’augmenter la bande passante nécessaire par rapport au 50 ou 60p, du fait que la vidéo soit encodée avec des “variable bit rates” qui s’adaptent au débit disponible.

• Voici la même séquence rapide filmée par le laboratoire de la BBC à 100 images par secondes avec un temps d'ouverture de la caméra de 1/320 s ( a gauche ) et filmée à 50 images par secondes avec un temps d'ouverture de la caméra de 1/200 s ( à droite ) :

Le laboratoire R&D de la BBC insiste sur le fait que le 140hz ( en progressif ) est la limite basse pour éviter l'augmentation des artefact de type motion-blurr et judder. Cela est notamment du au rapprochement de la distance de visionnage qui rend ces artefacts plus visibles. C'est pour cette raison que mi 2014, le SMPTE modifiera de nouveau ses standards UHDTV pour ajouter de nouvelles hautes fréquences ( 100Hz et 120/1,001 Hz ). Au final le choix de la fréquence reviendra aux diffuseurs en fonction de la bande passante disponible et des capacités de leur matériel de captation.

• Au cinéma, James Cameron va filmer Avatar 2 & 3 en 48 hz ( au lieu de 24hz ). Peter Jackson à tourné le Hobbit 1, 2 et 3 à 48 images/s.

Les problématiques à prendre en compte :

Même pour des résolutions HD, le flou de mouvement du à la camera réduit la résolution perceptible :

•Lorsque la camera effectue un pan/travelling sur une scène.

•Contrainte de vitesse maximale de travelling vs perception.

•Désagréable lors de changements de plans fixe / mouvement.

Il est nécessaire de réduire le shutter camera (durée d’ouverture) et de trouver l'équilibre :

•Une définition tranchante « comme un rasoir » n’est pas forcement meilleure… nécessité pour l’oeil de percevoir le mouvement.

•Il faut que le système visuel humain effectue la « fusion » des images.

Les différentes problématiques à prendre en compte pour la production de contenus sont :

• Le flicker du display, autrement dit la fréquence de rafraîchissement du backlight du téléviseur qui est indépendante de la fréquence de captation du contenu diffusé.

• Le shutter camera (durée d’ouverture) pour obtenir des images avec détails.

• La capacité du système visuel humain pour fusionner les images.

• Les problématiques d’éclairage, plus le temps d'ouverture est faible, moins de lumière est captée par la caméra ce qui impose des conditions d'éclairages adaptées.

• La conversion de standards entre SDR et HDR.

• La performance globale au bruit, autrement dit trouver les bons paramètres de compressions.

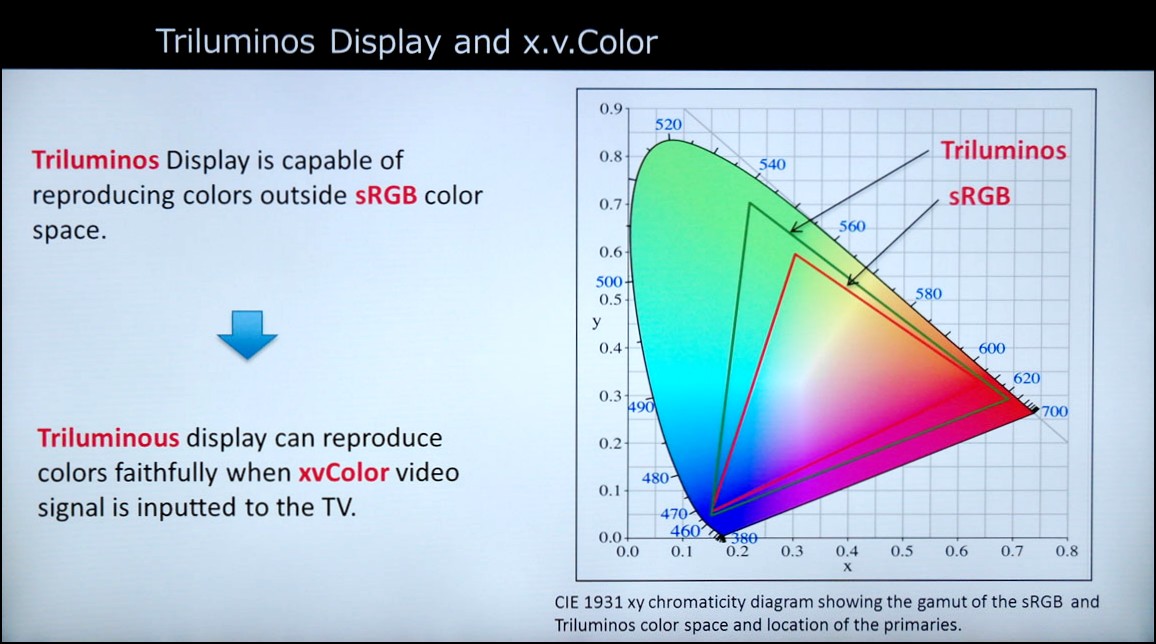

Le Rec.2020 ( ou BT.2020 ) :

Le Rec. 2020 est définit le 23 août 2013 par l'International Telecommunication Union ( ITU ) comme espace colorimétrique retenu pour l'UHD. Il couvre 75,8% du diagramme C.I.E. ( et permet de bénéficier du rendu colorimétrique du cinéma ) alors que le Rec.709 de l'HDTV ne recouvre que 35,9% de ce diagramme C.I.E..

A l'intérieur de l'espace colorimétrique Rec.2020, les coordonnées du blanc sont définies par le standard international D65. Le D65 correspond à une lumière naturelle en plein jour à midi en zone tempérée, donc une température du blanc d’environ 6 500 K. D'après Joe Kane, le standard D60 serait plus réaliste pour fixer les coordonnées du point blanc dans la zone couverte par le Rec.2020. Le standard D60 correspond à une lumière du jour de milieu de matinée / milieu d’après midi, ayant une température du blanc d'environ 6000 K, donc un peu plus "chaude" que le standard D65.

L'image ci dessous montre que la représentation réelle des couleurs des objets nous entourant dépasse bien souvent l'espace colorimétrique du Rec.709 mais est toujours contenue dans l'espace colorimétrique Rec.2020 :

Le Rec.2020 autorise l'utilisation des signaux RGB ou YUV ( en 4:4:4, 4:2:2, et 4:2:0 ). Enfin, le Rec.2020 est supporté par les formats d'encodages HEVC/H.265 et AVC/H.264. A noter que dans un premier temps les premières sources UHD ou 4K risquent d'être encodées selon l'espace colorimétrique Rec.709 en raison de sa large généralisation dans nos équipements.

Pour les vidéos ( films, concerts, documentaires ) stockés sur support physique optique ( Ultra UH Blu-ray ):

Les spécifications de l'ultra Blu-ray diffusées en janvier 2015 précisent que les espaces colorimétriques suivants sont autorisés :

• BT.709 ( vidéo forcément non HDR ),

• BT.2020 ( vidéo en HDR ou non HDR ).

Pour la diffusion TV ( Broadcasting c'est à dire via satellite ou TNT, Broadbanding c'est à dire via boîtier internet ou live via site internet ) :

Le standard UHDTV de SMPTE retient toujours le Rec.2020 somme cible référence pour l'UHDTV1 et UHDTV2. Le Rec.709 reste quand même autorisé pour le déploiement de l'UHDTV1 jusqu'en 2017 ( date de sa possible suppression ) du fait de sa généralisation dans la totalité des diffuseurs. Selon SMPTE, aucun diffuseur du marché grand public ne permet actuellement d'afficher l'espace colorimétrique Rec.2020. En mars 2014, SMPTE précise que des travaux sont actuellement menés pour spécifier la bonne façon de convertir des formats de colorimétrie de sources vidéos non Rec.2020 en UHDTV Rec.2020.

Pour les vidéos ( films, concerts, documentaires ) disponible en streaming ou via des sites de vidéo à la demande :

Il semblerait que pour un long moment les fournisseur de services de vidéo à la demande ou de streaming, obligé de "taper" dans leur stock de vidéos existantes, se contenteront du Rec.709. le Rec.2020 devrait voir le jour sur internet lorsque la télévision aura adopté cette norme, c'est à dire pas avant 2017 au plus tôt.

Rappel sur le signal YCbCr :

Comme vous le savez sans doute, les images en couleur sont reproduites sur pratiquement tous les écrans en combinant rouge, vert et bleu (RVB en Français ou RGB en anglais). Le signal RVB peut être transformé en une autre représentation appelée YCbCr, qui se compose d'un canal de luminosité en noir et blanc (Y) et deux canaux dits de différence de couleur (Cb et Cr). Après cette transformation, le signal YCbCr peut être connu en tant que :

• 4:4:4 parce que, pour tous les quatre pixels de Y sur chaque ligne horizontale du signal vidéo, il y a aussi quatre Cb et Cr pixels sur les lignes paires et quatre Cb et Cr pixels sur les lignes impaires. Comme cela fait beaucoup de données et que le système visuel humain est beaucoup plus sensible à la luminosité que à la couleur, on a tendance à réduire le nombre d'infos Cb et Cr pour obtenir un signal en 4:2:2 ou 4:2:0.

• 4:2:2 parce que, pour tous les quatre pixels de Y sur chaque ligne horizontale du signal vidéo, il y a deux pixels Cb et Cr pixels sur les lignes paires et deux Cb et Cr pixels sur les lignes impaires. Cela équivaut à couper la définition horizontale de l'information de couleur de moitié.

• 4:2:0 parce que, pour tous les quatre pixels de Y sur chaque ligne horizontale du signal vidéo, il y a deux pixels Cb et Cr pixels sur les lignes paires et aucun Cb et Cr pixels sur les lignes impaires. Cela équivaut à couper la définition horizontale et verticale de l'information de couleur de moitié.

Dans les deux cas ( 4:2:2 et 4:2:0 ), les informations de couleur sont reconstruites en utilisant l'interpolation, dans lequel un processeur vidéo recrée les pixels manquants mais avec moins de précision.

Remarque : Une image vidéo en UHD 4:2:0 a ses 2 plans de chroma Cb et Cr en définition 1920x1080, donc il n'y a pas besoin de les downscaler en définition Full HD, ils sont nativement à cette définition ( aucune perte d'info de chroma lors du passage UHD vers Full HD ). Seul le plan Y' de définition 3840x2160 doit être downscalé en définition Full HD ( ce qui rend cette opération de downscale très rapide ). Au final, après downscale, les 3 plans Y'CbCr sont donc en Full HD, donc en 4:4:4. Autrement dit, un signal vidéo UHD en 4:2:0 donne du Full HD en 4:4:4 après downscaling ( merci à Emmanuel Piat pour cette explication ).

Pour les vidéos ( films, concerts, documentaires ) stockés sur support physique optique ( Ultra HD Blu-ray ):

Les spécifications de l'ultra Blu-ray diffusées en janvier 2015 précisent que seule la représentation YCbCr 4:2:0 sera exploitée.

A noter que les films disponibles en Blu-Ray ou DVD sont tous distribués en YCbCr 4:2:0.

Pour la diffusion TV ( Broadcasting c'est à dire via satellite ou TNT, Broadbanding c'est à dire via boîtier internet ou live via site internet ) :

Le standard UHDTV de SMPTE autorise les trois représentations possibles en YCbCr. Jusqu'à présent, les captations se faisaient en 4:2:2, plus rarement en 4:4:4 et la diffusion se faisait en 4:2:0. Le consortium DVB, qui spécifie les paramètres type des signaux UHD télévisé exploitable en Europe, a fixé en janvier 2014 le 4:2:0 comme unique représentation possible lors de la phase d'introduction de l'UHD-1. Des négociations sont en cours pour que l'UHD-1 ( 2ème phase qui devrait voir le jour à partir de 2017 ) puisse être distribué en 4:2:2, voie en 4:4:4.

Pour les vidéos ( films, concerts, documentaires ) disponible en streaming ou via des sites de vidéo à la demande :

Du fait de la problématique liée à la faible bande passante internet disponible chez la majorité des consommateurs, la représentation en 4:2:0 restera longtemps le format de représentation référence sur le net.

Généralités :

La profondeur de couleur est le nombre de bits utilisés pour représenter la luminosité d'une composante de couleur ( rouge, vert ou bleu ). La norme actuelle est de 8 bits, ce qui représente 256 mesures de luminosité pour chaque composante de couleur. La couleur finale d'un pixel étant un mélange de rouge, de vert et de bleu ; un pixel est donc encodé sous 24 bits.

Le Rec.2020 :

Le Rec.2020 définit un encodage d'une composante de couleur, appelé aussi profondeur de couleur, sur 10 bits ou 12 bits. Exploiter l'espace colorimétrique Rec.2020 revient à encoder un pixel sur 30 bits ( 3x10 bits ) ou 36 bits ( 3x12 bits ) pour les données décrivant sa luminance et par conséquent sa colorimétrie. La profondeur de couleur sur 8 bits est définitivement abandonnée par l'espace colorimétrique Rec.2020 permettant ainsi de lisser les dégradés de couleurs et éviter le phénomène connue sous le nom de Banding :

A gauche : profondeur de couleur 8bits ( généralement exploité via le Rec.709 ).

Au milieu : profondeur de couleur 10 bits ( minimum envisagé via le Rec.2020).

A droite : profondeur de couleur 12 bits ( maximum envisagé via le Rec.2020).

Pour les vidéos ( films, concerts, documentaires ) stockés sur support physique optique ( Ultra HD Blu-ray ):

Les spécifications de l'ultra Blu-ray diffusées en janvier 2015 précisent deux profondeur de couleur autorisées :

• 8 bits si encodage en AVC,

• 10 bits si encodage en HEVC.

Pour la diffusion TV ( Broadcasting c'est à dire via satellite ou TNT, Broadbanding c'est à dire via boîtier internet ou live via site internet ) :

Le consortium DVB, qui spécifie les paramètres type des signaux UHD télévisé exploitable en Europe ( l'UHD-1 et UHD-2 ), a fixé en janvier 2014 une profondeur de couleur unique de 10bits pour la phase d'introduction de l'UHD-1. Le 8 bits est donc abandonné définitivement pour les futures chaînes UHDTV diffusées en Europe. Des négociations sont en cours pour que l'UHD-1 ( 2ème phase qui devrait voir le jour à partir de 2017 ) puisse être distribué aussi en 12 bits. Cet abandon du 8bits permet d'anticiper l'arrivée d'une autre fonctionnalité attendue de l'UHDTV à savoir le High Dynamic Range ( HDR ). Le HDR fonctionne avec un résultat dégradé sur des signaux vidéos dont les primaires sont encodées en 8 bits d'où l'officialisation du 10 bits minimum.

Pour les vidéos ( films, concerts, documentaires ) disponible en streaming ou via des sites de vidéo à la demande :

Du fait de la problématique liée à la faible bande passante internet disponible chez la majorité des consommateurs, le codage en 8 bits restera longtemps le format de représentation référence sur le net.

Rappel :

L'imagerie à grande gamme dynamique (high dynamic range ou HDR) regroupe un ensemble de techniques numériques permettant de représenter ou de mémoriser de nombreux niveaux d'intensité lumineuse dans une image. D'abord développée pour les images générées par ordinateur, la technique s'est ensuite adaptée à la photographie numérique et concerne désormais aussi la vidéo. Que ce soit pour un appareil photo ou pour une caméra vidéo, la problématique reste la même : différents paramètres ( temps d'exposition, ouverture, sensibilité ) sont ajustés ( automatiquement ou par l'utilisateur ) au moment de la captation d'image pour obtenir une photo/vidéo. Ces paramètres ne permettent jamais aux capteurs numériques de mémoriser la pleine échelle de lumière d'une scène/paysage.

L'obtention d'une photographie HDR peut se faire avec un appareil traditionnel en prenant plusieurs photos SDR (Standard Dynamic Range) d'une même scène/paysage puis en les fusionnant avec un logiciel. Si la technique est bien réalisée, on obtient alors une image aussi bien détaillée dans ses zones claires que sombres. La photo ( prise en HDR ) ci dessus montre qu'il y a un rapport de 5000 entre la partie la plus sombre et la partie la plus claire de l'image, ce qu'aucun capteur numérique n'est capable de retranscrire de façon lisible en une seule prise de vue.

HDR en vidéo :

Bénéficier des effets de la technologie HDR implique certaines conditions :

1 - Il faut réaliser la captation en HDR ( et en une seule prise de vue contrairement à la photographie ) à l'aide d'un jeux de deux caméras, d'un miroir et de filtre assurant la captation en sous exposition et en sur exposition en même temps. Il est impératif d'utiliser des caméras vidéos capable d'exploiter une profondeur de couleur d'au moins 10 bits sous peine de ne pas pouvoir extraire des informations utiles pour la partie HDR.

2 - La seconde condition concerne l'obligation d'un traitement spécifique des deux flux vidéos afin d'obtenir une vidéo "classique" accompagnée de ses données HDR. On commence par apporter des corrections géométriques aux deux vidéos ( celle surexposée et celle sous-exposée ) pour être en mesure de les fusionner. Puis, on va analyser les composantes Y ( luminance ) de chacune des deux vidéos pour séparer les informations communes de celles spécifiques à chaque vidéo. Les informations communes de luminance sont fusionnées dans un 1er canal ( SDR ou non HDR ) qui deviendra la composante de luminance Y de la vidéo finale. Les informations de luminance spécifiques aux deux vidéos sont fusionnées dans un 2nd canal ( lui aussi SDR ). Enfin des informations de synchronisation utiles pour la colorimétrie en cas d'affichage HDR sont extraites en métadonnées. Les deux canaux de luminance sont encodés et compressés ( séparément ) puis fusionnées avec les données de couleur pour obtenir un seul flux vidéo ( intégrant les métadonnées HDR ). Il ne reste plus qu'à convertir la vidéo finale ( choix de la définition, de la profondeur de couleur, de l'espace colorimétrique ) puis la stocker avant de pouvoir la distribuer.

Les données HDR sont donc composées d'un canal de luminance supplémentaire ainsi que de métas-données entourant le flux vidéo "classique". Cette séparation de la luminance permet de garantir une compatibilité descendante. Ainsi, un diffuseur SDR ( Standard Dynamic Range ) ne peut pas être upgradé en HDR ( High Dynamic Range ) mais il pourra afficher ( de façon non HDR ) un média encodé en HDR.

3 - le diffuseur ( téléviseur ou vidéo-projecteur ) doit satisfaire des caractéristiques minimales ( non standardisées à ce jour ) pour être compatible HDR.

Les promesses chiffrées du HDR :

Voici tout d'abord des valeurs de luminosité ( exprimées en nits ) mesurées dans un scène sombre et ensoleillée. On remarque clairement les différences de gammes entre les valeurs les plus faibles et les plus élevées :

L'image ci-dessous permet de comparer la pleine échelle de lumière mesurable, celle visible par le système visuel humain et celle capable d'être reproduite par des diffuseurs SDR ( Standard Dynamic Range ) actuels ( téléviseurs et vidéo projecteurs de cinéma ). On remarque clairement l'écart immense entre ce que le système optique peut percevoir et ce qui lui est retransmis par la télévision ou au cinéma :

Valeurs de blanc et noir standardisées :

• Valeurs de blanc : La norme au cinéma est de 48 cd/m2 et entre 80 et 120 cd/m2 pour les téléviseurs. Un moniteur LCD affiche au mieux 300 cd/m2 ( ou 300 nits ), les meilleurs téléviseurs actuels ( non HDR ) vont jusqu'à 1500 cd/m2 et les premiers moniteurs HDR permettent d'atteindre les 5000 cd/m2.

• Valeurs de noir : La norme au cinéma est entre 0,01 et 0,03 cd/m2 et entre 0,005 et 0,01 cd/m2 pour les téléviseurs. Les meilleurs téléviseurs actuels ( non HDR ) vont jusqu'à 0,001 cd/m2. La limite de perception humaine étant à 0,00001 cd/m2.

Augmenter la dynamique des images visible à l'écran fait partit des nouveaux aspects que l'industrie de l'audiovisuel à tenu à prendre en considération lors des spécifications de l'ultra HD. Il s'agit ici d'augmenter le réalisme des images et donc l'immersion du spectateur en définissant de nouvelles valeurs normés pour les valeurs crêtes de blanc et noir affichable. L'accroissement de ces valeurs augmentera ainsi le contraste du diffuseur qui reposait jusqu'alors sur des normes vieillissantes.

Voici une image extraite d'une séquence filmée et encodée en HDR ( caméra F65 Sony, 1080p à 25 images/s, Rec.709 ) et diffusée depuis un moniteur professionnel SIM2 HDR47E S 4K équipé d'un système HDR :

Voici la comparaison simultanée d'une même séquence vidéo traitée ( comprendre encodée ) à la fois classiquement ( SDR ) et traitée en HDR ( démonstration réalisé par 4ever sur un moniteur HDR SIM2 ):

Problématiques liées aux diffuseurs :

En pratique, augmenter la gamme dynamique de nos diffuseurs implique des problématiques différentes entre téléviseurs et vidéos projecteurs :

• pour les téléviseurs, on sait que seule la technologie OLED pourrait permettre de tels niveaux de contraste. Le problème c'est que l'OLED vieillit mal et rapidement ce qui génère une instabilité en matière de colorimétrie. Les laboratoires chimiques comme BASF cherchent des matières organiques de substitution afin de réduire les coûts de fabrication et de maîtriser les dérives temporelles en matières de colorimétrie mais du coup, ces nouveaux composés organiques s'avèrent moins intenses en luminosité. Le HDR aura donc un effet maximum sur des téléviseurs Oled première génération, puis viennent ensuite les téléviseurs Oled avec des composés organiques de substitutions et enfin les téléviseurs LED dont la gamme dynamique de contraste est sensiblement diminué par rapport à l'Oled. Autrement dit, préférer un téléviseur OLED si le HDR vous est primordial.

• En vidéo projection, aucune technologie existante ne permet de diffuser de l'HDR correctement. Il faudra attendre la généralisation de la technologie full laser avec des niveaux de luminosité fantastique pour égaler ce que l'on verra sur un téléviseur OLED.

• Quel que soit le diffuseur ( Téléviseur ou vidéoprojecteur ), augmenter la gamme dynamique de contraste revient aussi à augmenter proportionnellement la consommation électrique ! A tel point que le consortium DigitalEurope est en cours de discussion avec l'Union Européenne afin de définir le niveau maximum d'illumination ( et donc de consommation électrique ) autorisé pour les téléviseurs commercialisés sur le sol Européen. De même, l'industrie vidéo qui depuis quelques années a fait beaucoup d'effort pour communiquer sur les aspects "Vert" de ses productions commence à intégrer la nécessité de concevoir des produits intégrant des limites en matières de consommation d'énergie. Il est néanmoins probable que les pics de contraste et de luminosité varient en fonction du type de diffuseur : autrement dit, les modèles haut de gamme iront plus loin que les modèles d'entrée de gamme.

• Dernière chose, le HDR ne marche que sur des médias encodés en 10 bits. Il faut donc que le diffuseur ( télévision, écran PC, vidéo-projecteur ) soit capable d'adresser chaque pixel en 10 bits. Si les électroniques des vidéos projecteurs supportent le 10 bits voir le 12 bits pour les haut de gamme, ce n'est pas le cas des téléviseurs dont + de 95% sont équipées de dalles adressables qu'en 8 bits.

L'autre partie du problème est la fonction de transfert opto- électronique ( OETF ) utilisée pour convertir des images optiques de la caméra en signaux électroniques et la fonction ( inverse ) de transfert électro-optique ( EOTF ) utilisée pour convertir les signaux électronique en image à l'écran. Toutes deux sont actuellement basées sur la notion de gamma utilisée dans tous les téléviseurs. Nos diffuseurs se comportent de telle manière que lorsque l'amplitude du signal d'entrée est faible, il ne réagissent que très peu à ce signal ou à ses variations de faibles amplitudes et ne les reproduisent pas. Le gamma est une correction mathématique opérée pour relier l'amplitude de la luminance (en volt) d’un signal de télévision et la luminance (en cd/m²) réelle de l'image sur un diffuseur. Cette correction a néanmoins des inconvénients car, si le gamma est réglé trop haut ( > 2,4 ), les détails des scènes sombres ne seront pas affichés. A contrario, un gamma réglé trop bas ( <1,8 ) et l'on perdra la densité des noirs affichés. De plus, un gamma mal réglé peut intensifier le phénomène de banding visible sur les parties lumineuse d'une scène à fort contraste ; ce phénomène étant en majeure partie liée à la profondeur de bit utilisé pour encoder un signal vidéo. Les questions liées à la profondeur de bit et au Banding dépendent donc du gamma utilisé sur l'afficheur. Malgré la possibilité de modifier manuellement le gamma de nos diffuseurs, il n'y a pas de réglage standard ( ou recommandé ) en fonction de l'espace colorimétrique exploité par la vidéo que l'on regarde. Ni l'espace colorimétrique Rec.709, ni le Rec.2020 ne spécifient un EOTF. Un gamma de 2.4 est spécifié dans le Rec.1886, et le Rec.2020 l'utilise pour l'instant.

Le Dolby vision :

Afin de réduire le Banding, notamment lors des valeurs élevées de luminance, la société Dolby développe une nouvelle EOTF appelée quantification Perceptuelle (PQ). Dolby affirme que ce système peut améliorer les dégradés de couleurs dans l'affichage des hautes lumières, des reflets du soleil ou des feux d'artifice, ainsi que les détails à bas niveaux de lumière. En fait, la société affirme qu'une profondeur de couleur de 12 bits en PQ équivaut à une profondeur de couleur de 14 bits en EOTF basé sur le gamma.

Sur l'image ci-dessus, le trait en pointillé représente la limite au dessus de laquelle du banding apparaît et en dessous de laquelle le banding n'apparaît pas.

La courbe en verte représente une profondeur de couleur de 10 bits en PQ, du banding peut alors apparaître.

La courbe en noir représente une profondeur de couleur de 12 bits en PQ, du banding ne peut pas apparaître.

Voici les projections de résultats attendus par la technologie Dolby Vision associées à l'espace colorimétrique Rec 2020 :

Standardisation du HDR :

Basé sur les travaux expérimentaux de Dolby et de l'EBU ( publiés en juin 2013 ), ainsi que sur des propositions techniques de la BBC, de Philips ou encore de Technicolor, le SMPTE a décidé de formaliser trois spécifications qui permettront l'exploitation d'un standard HDR open source ( SMPTE-2084,2085,2086 ). Cela impacte d'abord les diffuseurs qui devront avoir les capacités d'afficher les nouvelles valeurs crêtes de blanc et de noir attendues. Cela affecte ensuite la façon dont les signaux vidéos UHD et UHDTV sont préparés ( masterisés ) avant d'être distribués. Enfin cela affecte la captation d'image vidéo.

Le 10 septembre 2014, le SMPTE a officialisé le standard HDR au travers de la norme SMPTE ST2084 qui définit la façon de convertir les médias existants non HDR en HDR ( donc hors broadcasting ). C'est dans cette norme que l'on retrouve le gamma du HDR ( basée sur la solution PQ de Dolby vision ).

En novembre 2014, le SMPTE a officialisé le standard HDR au travers de la norme SMPTE ST2086 qui définit la façon dont les données HDR doivent être présentées en métas-données. C'est dans cette norme que l'on retrouve la solution de Technicolor qui garantit la compatibilité des médias HDR avec des diffuseurs non HDR.

Le consortium HDMI a établi la norme HDMI 2.0a en avril 2015 qui autorise les médias encodés en HDR à transiter via le câble HDMI.

Le 30 janvier 2015, le CEA publie la norme "HDR Static Metadata Extensions" nommé CEA-861.3. Cette norme spécifie comment coder et décoder ( comprendre afficher ) les métadonnées ( structures de données ) de type HDR sur des vidéos à usage domestique. Cette norme du CEA est compatible avec les normes SMPTE ST 2084 et SMPTE ST 2086 tout en contenant des dispositions pour les futurs EOTFs HDR ( PQ de DOLBY, ... ). Les exigences de cette norme complètent la CEA-861-F.

Le 27 août 2015, le CEA a produit une directive à l'attention des fabricants TV, fournisseurs de contenus et distributeurs, ayant pour objectif d'assister les revendeurs et le consommateur à reconnaître facilement quels diffuseurs seront en mesure d'afficher du contenu Ultra HD avec HDR. Un TV, moniteur ou projecteur peut être désigné comme diffuseur compatible HDR s'il répond aux attributs minimaux suivants :

• Inclut au moins une interface capable de prendre en charge la signalisation HDR tel que défini dans le CEA-861-F, et prorogé par le CEA-861.3,

• Reçoit et traite les métadonnées statiques HDR compatible avec le CEA-861.3 pour la vidéo non compressée,

• Reçoit et traite le profil multimédia HDR10* en IP, HDMI ou provenant d'autres sources de diffusion vidéo. En compléments, d'autres profils multimédias pourront être supportés,

• Applique de manière appropriée une fonction de transfert électro-optique (EOTF) avant d'afficher une image.

* Le profil HDR10 est celui qui sera exploité sur l'ultra HD Bluray ( 10 bits par couleur, 4:2:0 pour les vidéos compressées, Rec.2020, compatible SMPTE 2084 et 2068 ).

La liste des téléviseurs compatibles HDR10 ( au jour de septembre 2015 ) serait donc celle-ci, sachant qu'une TV UHD compatible Dolby Vision est également compatible HDR10 :

• LG EG960V et EF950V

• Panasonic CX850

• Samsung JS9500

• Sharp UH30

• Sony XBR 930C / 940C (2015 update)

• Vizio R-series

• Hisense 65H10/65XT910

Pour les vidéos ( films, concerts, documentaires ) stockés sur support physique ( Ultra HD Bluray ):

Les spécifications de l'ultra Blu-ray diffusées en janvier 2015 précisent les types d'HDR autorisés :

• HDR open source ( voir normes SMPTE-ST2084 et SMPTE-ST2086), donc avec des pics de luminances compris entre 1,000 nits et 10,000 nits.

• HDR propriétaires, donc possibilité d'encoder les vidéos avec le système Dolby Vision ou le système Philips HDR.

Pour la diffusion TV ( Broadcasting c'est à dire via satellite ou TNT, Broadbanding c'est à dire via boîtier internet ou live via site internet ) :

Le consortium DVB, qui spécifie les paramètres type des signaux UHD télévisé exploitable en Europe, a fixé en janvier 2014 que l'HDR ne ferait pas partit des paramètres figés lors de la phase d'introduction de l'UHD-1. En revanche, l'HDR est d'ors et déjà officialisé pour que l'UHD-1 ( 2ème phase qui devrait voir le jour à partir de 2017 ) puisse être distribué avec des signaux compatible avec cette fonctionnalité.

Pour les vidéos ( films, concerts, documentaires ) disponible en streaming ou via des sites de vidéo à la demande :

Il est vraisemblable de penser que nos moniteurs informatique ( comme nos autres diffuseurs ) seront équipés petit à petit de la fonctionnalité HDR et donc équipés d'électroniques pouvant afficher des vidéos encodés sur 10 bits. On peut supposer que des vidéos HDR seront aussi disponible en téléchargement sans difficulté majeures pour les diffuseurs. Dans tous les cas, les vidéos dites HDR devront respecter la norme CEA-861.3 et par conséquent la norme CEA-861-F.

Généralités :

L'augmentation des pixels liée à l'ultra HD augmente la taille des informations qu'il faut pouvoir traiter et encoder :

Le schéma ci dessus montre qu'il y a 40 fois plus de données à enregistrer entre une vidéo de définition SD et une vidéo de définition UHD-1. Pour pouvoir diffuser ces vidéos ( via support physique ou via broadcasting ou via Broadband ) il est nécessaire d'exploiter un format de compression plus performant que ceux actuellement utilisés.

Le HEVC :

Le 13 avril 2013, le High Efficiency Video Coding ( HEVC/H.265 ) est devenu le standard de compression vidéo sans perte retenu pour l'UHD. Il succède à l'Advanced Vidéo Coding AVC/H.264 (de 2003) avec un taux de compression deux fois meilleur à iso qualité ( 1 pour 250 environ ). A noter que par rapport au MPEG-2 (1994), le gain passe à 75%. Côté expérimentation des débits nécessaires, l’UHD ( 4:2:0 / 8 bits / 60hz ) encodé via HEVC est regardable avec un débit entre 12 et 20 Mbit/s contre un débit compris entre 24 et 45 mbits/s, pour ce même signal encodé en AVC :

Après un an d'expérimentations pour comprendre et définir les bonnes pratiques à son exploitation, le HEVC version 2 ( HEVC Range Extension ou HEVC-RExt ) est standardisé en Juillet 2014. Les évolutions concernent l’extension des espaces couleurs (au-delà du 4:2:0 et du 10 bits/couleur) pour l’intégration dans l’amont des chaines de production, à la gestion intégrée de la 3D, à celle de plusieurs définitions dans un même codec et enfin, d’un profil avec des frames JPEG2000 éditables qui sont utilisées pour certaines productions.

Voila un tableau récapitulatif des différents profils autorisés en version 1 et 2 du HEVC :

Les trois profils initiaux de la version 1 ( 2 pour la vidéo, un pour l'imagerie non visible dans ce tableau ) n'exploitent que le 4:2:0 en 8 ou 10 bits. La version 2 apporte des profils exploitants le 4:2:2 et le 4:4:4 sur 8, 10,12 et 16 bits.

Voila un tableau récapitulatif des différents niveaux autorisés en HEVC ( pas de nouveaux niveaux entre la version 1 et 2 mais certaines caractéristiques internes aux niveaux ont évoluées ) :

Le HEVC définit 13 niveaux de qualité d'encodage ce qui signifie qu'il est utilisable à des définitions inférieures à celles de l'UHD, y compris sur des signaux entrelacés, les trois derniers niveaux étant réservés pour le traitement des vidéos en 8K. A partir du niveau 5 on autorise la définition de l'UHD. Le Blu-Ray actuel à un débit maximum autorisé pour le flux vidéo de 40Mbit/s ce qui correspond au niveau 5.1 pour l'UHD@HEVC.

La contre partie est que l'encodage HEVC nécessite 10 fois plus de puissance de calcul que l'AVC à l'encodage et 2 à 3 fois plus de puissance que l'AVC au décodage. C'est essentiellement due aux évolutions des algorithmes de compression d'image listées ci dessous :

L'exploitation du HEVC va être bénéfique dans de nombreux domaines d'applications puisque l'on peut ainsi diffuser la même qualité de vidéo avec 2x moins de débit nécessaire ( et déployer plus de chaînes sur un même transpondeur satellite ou sur un multiplex de la TNT par ex. ), où alors augmenter la qualité vidéo par deux en conservant un débit identique ( diffuser une vidéo Full HD au lieu d'une vidéo HD Ready sans coûts supplémentaires pour le consommateur par exemple).

Le fabricants majeurs comme Apple et Microsoft garantissent déjà la compatibilité de leur produit avec le HEVC. Le HEVC est aussi compatible avec la plupart des formats de fichiers vidéos informatiques comme le conteneur de fichier Matroska ( MKV ) ou le nouveau conteneur MPEG ( en cours de développement ). Les téléviseurs récents haut de gamme sont tous compatibles HEVC et son adoption va continuer à s'étendre vers d'autres types de produits ( décodeurs stellites, amplis HC, lecteur Blu-Ray, scalers, ... ).

Si le HEVC peut être exploité avec des signaux qui ne sont pas UHD ou UHDTV, l'UHD et l'UHDTV ne peuvent exister sans HEVC.